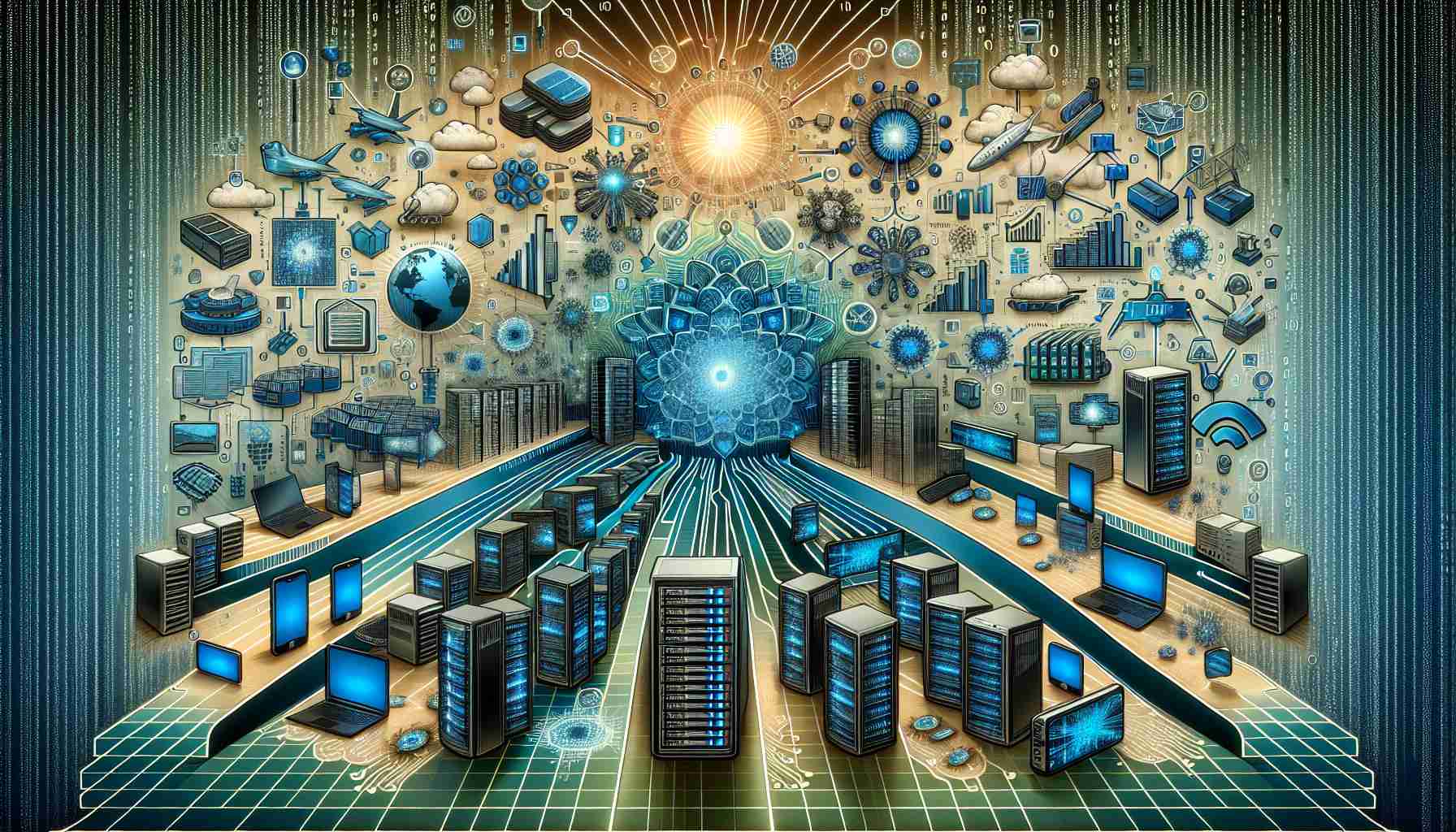

W miarę jak firmy korzystają z potencjału sztucznej inteligencji (AI) w swoich operacjach biznesowych, krajobraz obciążeń pracy AI przechodzi znaczącą zmianę. Tradycyjnie obciążenia AI były przetwarzane w centrach danych, wymagając specjalistycznego i kosztownego sprzętu do szkolenia modeli. Jednak w miarę rozwoju dziedziny AI, obserwuje się rosnącą tendencję ku obciążeniom opartym na wnioskowaniu i optymalizacji istniejących modeli. Ta zmiana otwiera nowe możliwości dla AI jako usługi, świadczonej przez głównych dostawców usług chmurowych.

W centrach danych pojawia się nowa tendencja wykorzystywania tradycyjnych serwerów do obciążeń AI. Ten ruch ku bardziej ekonomicznym rozwiązaniom stanowi znaczną korzyść dla ugruntowanych graczy na rynku centrów danych. W miarę jak powstają nowsze i bardziej wydajne metody modelowania, tradycyjne serwery potrafią obsłużyć te obciążenia z korzystnym stosunkiem kosztów do wydajności oraz większą dostępnością obliczeniową. Eliminuje to potrzebę, by firmy podejmowały istotne inwestycje kapitałowe w kosztowny sprzęt, który jest wymagany tylko do celów szkoleniowych.

Tymczasem przetwarzanie w krawędzi jest gotowe stać się głównym miejscem docelowym dla obciążeń AI w najbliższej przyszłości. Krawędź obejmuje szeroki zakres systemów i możliwości przetwarzania, począwszy od małych tablic czujników, po pojazdy autonomiczne i diagnostykę medyczną. Ta migracja ku systemom opartym na krawędzi oferuje liczne korzyści, w tym zmniejszone opóźnienia, poprawioną bezpieczeństwo i zwiększoną wydajność.

Aby wspierać kwitnący ekosystem przetwarzania w krawędzi, platformy i środowiska programistyczne typu open-source mają odgrywać kluczową rolę. W przeciwieństwie do rozwiązań własnościowych, takich jak CUDA od Nvidii, otwarte i kompatybilne ekosystemy jak Arm i x86 oferują kompatybilność względem różnych potrzeb obliczeniowych. Ta elastyczność ułatwia łatwą skalowalność i przenoszenie rozwiązań, ułatwiając płynną integrację obciążeń AI od urządzeń małoskalowych po środowiska obliczeniowe wielkoskalowe.

Szybki rozwój Internetu Rzeczy (IoT) stworzył dodatkową potrzebę skalowalnych rozwiązań w przestrzeni przetwarzania na krawędzi. W IoT urządzenia są często mniejsze i działają przy mniejszym poborze mocy, co sprawia, że istotne jest ustanowienie otwartego ekosystemu, który może sprostać tym konkretnym wymaganiom. W związku z tym współpraca między platformami open-source a rozwijającym się przemysłem IoT ma ogromny potencjał napędzania innowacji oraz dalszego postępu w dziedzinie AI.

Podsumowując, krajobraz obciążeń AI zmienia się z tradycyjnych centrów danych na środowiska przetwarzania w krawędzi. Pomimo tego, że centra danych nadal odgrywają ważną rolę, wzrost obciążeń opartych na wnioskowaniu i optymalizacja modeli generują zapotrzebowanie na rozwiązania ekonomiczne. Krawędź, dzięki swojemu zróżnicowanemu zakresowi systemów i możliwości przetwarzania, wyłania się jako przyszłe centrum obciążeń AI. W miarę tego przejścia, platformy i środowiska programistyczne typu open-source odegrają kluczową rolę w ułatwianiu kompatybilności i skalowalności w krajobrazie AI.