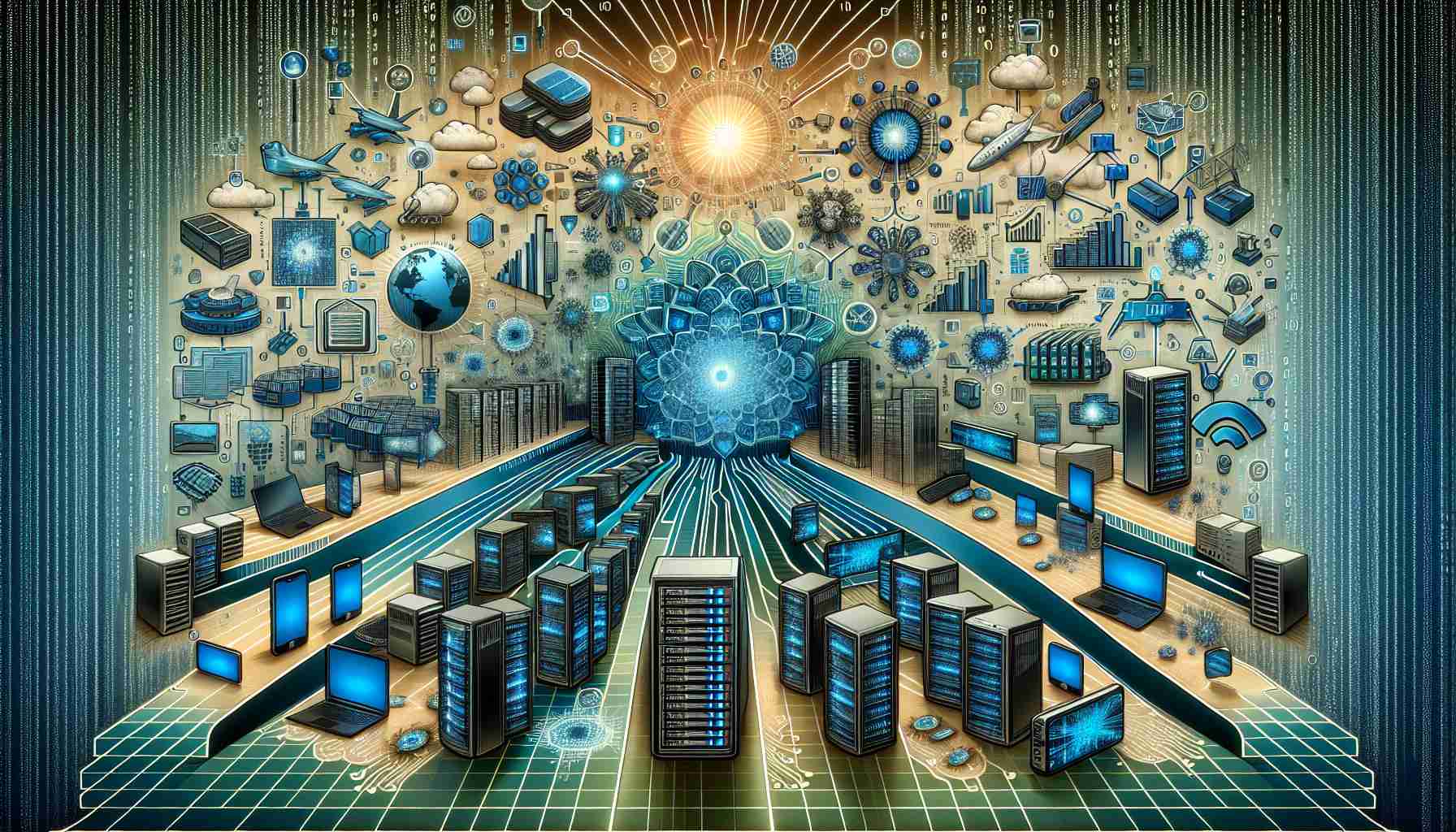

随着公司越来越多地接受人工智能(AI)在业务操作中的潜力,AI工作负载的格局正在发生重大转变。传统上,AI工作负载是在数据中心中处理的,需要专门且昂贵的硬件来训练模型。然而,随着AI领域的发展成熟,越来越多的工作负载转向推理为基础,并优化现有模型。这种转变为由主要云服务提供商提供的AI作为服务开辟了新的机会。

在数据中心,利用传统服务器处理AI工作负载的趋势正在兴起。这种转向更具成本效益的解决方案为数据中心业内的已建立的参与者提供了重要优势。随着更新和更有效的建模方法的出现,传统服务器可以以优越的成本/性能比率和更大的计算可用性处理这些工作负载。这消减了公司需要为训练目的而投资昂贵硬件的需求。

与此同时,边缘计算有望成为不久以后AI工作负载的主要目的地。边缘涵盖了各种系统和处理能力,从小型传感器组合到自动车辆和医疗诊断。这种向边缘系统的迁移提供了许多好处,包括降低延迟、增强安全性和提高效率。

为了支持边缘计算蓬勃发展的生态系统,开源平台和开发环境预计会发挥关键作用。与Nvidia的CUDA等专有解决方案不同,Arm和x86等开放且兼容的生态系统提供了跨不同计算需求的兼容性。这种灵活性使得容易扩展和移植解决方案,促进了从小型设备到大型计算环境的AI工作负载的无缝集成。

物联网(IoT)的迅速增长在边缘计算领域为需求可扩展的解决方案提供了额外需要。对于IoT来说,设备通常更小且在较低功耗下运行,这使得建立满足这些特定需求的开放生态系统至关重要。因此,开源平台与不断扩展的物联网行业之间的合作具有推动创新和进一步推进AI领域的巨大潜力。

总之,AI工作负载的格局正在从传统数据中心转向边缘计算环境。尽管数据中心继续发挥着重要作用,但基于推理的工作负载的崛起和模型的优化催生了对成本效益解决方案的需求。边缘系统凭借其各种系统和处理能力,正在成为未来AI工作负载的枢纽。随着这种转变的展开,开源平台和开发环境将在促进AI领域整体适配性和可扩展性方面发挥关键作用。